★ 도서 내용에 관한 질문은 깃허브 이슈 페이지에 남겨주세요. ★

# 2024년 11월 11일 종이책 3쇄 정오사항

* 이전 2쇄 및 전자책 v1.1을 구입하신 독자분들도 확인하시기 바랍니다.

p36. 본문 위에서 3째/5째 줄

오류율(26%)을 10% 가량 낮춘 → 오류율(26%)을 10%p 가량 낮춘

0.1% 더 낮추기도 쉽지 않았기 때문에 → 0.1%p 더 낮추기도 쉽지 않았기 때문에

p76. 그림 2.14 빨간 선 표시 부분

p92. 예제 2.15 디코더 구현 박스 안 아래에서 2째 줄 코드

mod(tgt, src) → mod(output, src)

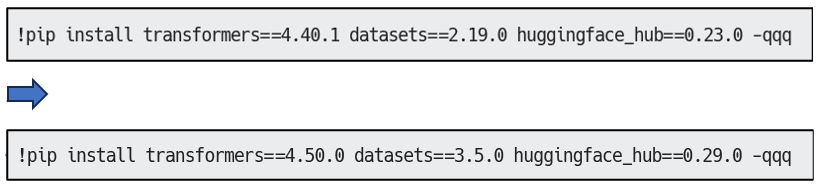

p102. 허깅페이스 트랜스포머 라이브러리 설치 변경

p120. 본문 밑에서 8째 줄

예제 3.9에서 → 예제 3.15에서

p123. 본문 위에서 8째 줄

그림 3.13의 → 그림 3.14의

p128. 예제 3.24 위에서 4째 줄

p130. 예제 3.27 아래에서 2째 줄

p166. 트랜스포머 라이브러리 설치 변경

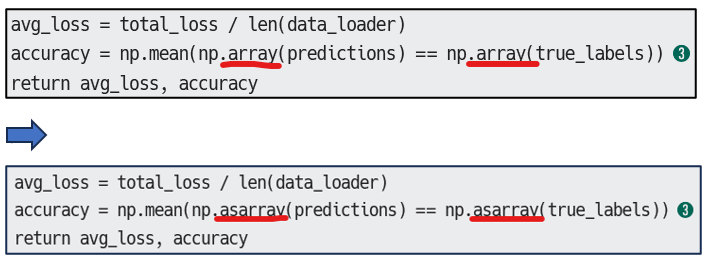

p175. 예제 5.3 첫째 줄

p259. 본문 위에서 1째 줄

딥러닝 모델으로 입력 데이터를 → 딥러닝 모델로 입력 데이터를

# 2024년 8월 12일 종이책 2쇄 정오사항

* 이전 1쇄 및 전자책 v1.0을 구입하신 독자분들도 확인하시기 바랍니다.

p63. 그림 2.2 내 절 번호 수정

2.1절 → 2.2절 / 2.2절 → 2.3절 / 2.3절 → 2.4절 / 2.4절 → 2.5절 / 2.5절 → 2.6절

p85. 본문 3째 줄

토큰 임베딩 차원(hidden_dim)을 → 토큰 임베딩 차원(embedding_dim)을

p90. 예제 2.13 코드부 수정

5행: query_length = querys.size(2) → query_length = querys.size(-2)

6행: key_length = keys.size(2) → key_length = keys.size(-2)

p91. 예제 2.14 코드부 수정 * 전자책 v1.0에는 반영됐습니다.

16행: (self.self_attn(x, x, x)) → self.self_attn(x, x, x, is_causal=is_causal))

19, 20행: encoder_output, is_causal=is_causal)) → encoder_output))

p126. 본문 4째 줄

에포크 수는 3으로 → 에포크 수는 1로

p216. 예제 6.5 아래 본문 3째 줄 * 전자책 v1.0에는 반영됐습니다.

150,000TPM(Transactions Per Minute)

→

150,000TPM(Tokens Per Minute)

p222-223. 예제 6.11 'LoRA 어댑터 결합 및 허깅페이스 허브 업로드' 코드부 변수명 수정 * 전자책 v1.0에는 반영됐습니다.

5행: start_model → base_model

16, 24, 25행: new_model → finetuned_model

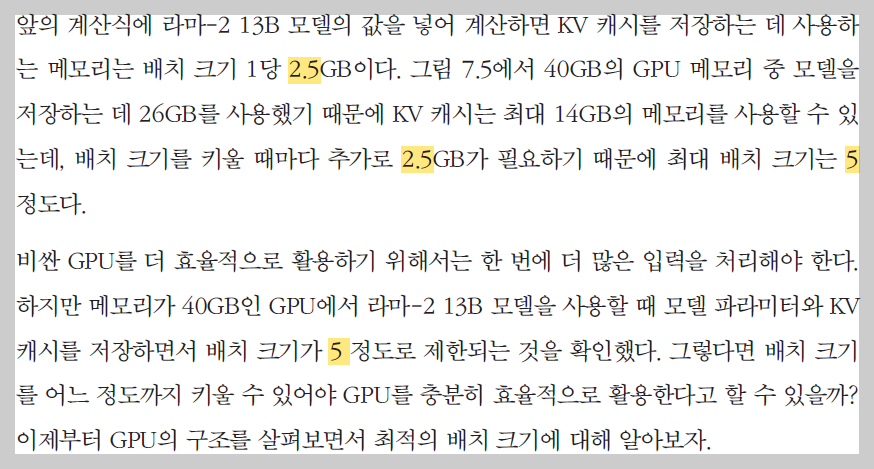

p235. 본문 2째, 4째, 8째 줄

2.5GB → 3.125GB

최대 배치 크기 5 → 최대 배치 크기 4

p271. 그림 8.17 아래 본문 1째 줄

RoPE(Rotary Positional Encoding) → RoPE(Rotary Positional Embedding)

ALiBI(Attention with Linear Biases) → ALiBi(Attention with Linear Biases)

p314. 예제 9.10 코드부 수정 (본문의 숫자 기호 누락, ❶❷❸❹ 추가)

p413. 본문 2째 줄

표 12.2를 보면 백만 개의 벡터를 저장할 때 필요한 메모리는 약 488MB인데, m을 64로 설정했을 때 두 배 이상의 메모리를 사용한다.

→

표 12.1을 보면 백만 개의 벡터를 저장할 때 필요한 메모리는 약 488MB이다. 표 12.2에서 m을 64로 설정하면 두 배 이상의 메모리를 사용한다.

p523. 표 16.1 RNN 장점 부분 수정

추론이 효율적(시퀀스 길이에 관계없이 일정한 시간)

→

추론이 효율적임(시퀀스 길이에 관계없이 토큰당 생성 시간 일정함)

p532. 표 16.4 표 항목 이름 수정

추론 연산량 → 토큰당 추론 연산량

# 2024년 7월 25일 종이책 1쇄 정오사항

p297. 코드부 2째 줄 -> llama-index-callbacks-wandb==0.1.2 코드부 추가

"nemoguardrails[openai]= =0.8.0" openai= =1.25.1 chromadb= =0.5.0 wandb= =0.16.6 -qqq

→

"nemoguardrails[openai]==0.8.0" openai==1.25.1 chromadb==0.5.0 wandb==0.16.6

llama-index-callbacks-wandb==0.1.2 -qqq

p324. 예제 9.16 코드부 6째 줄 아래 코드 2줄 추가

query = "대한민국의 수도는 어디야?"

temperature = 0.2

model_name = "gpt-3.5-turbo"

p325. 예제 9.16 코드부 ➊ 단락 코드 변경

response = client.chat.completions.create(model="gpt-3.5-turbo", ➊

messages=[{"role": "system", "content": system_message},{"role": "user", "content": query}],

temperature=0.7

)

→

response = client.chat.completions.create(model=model_name, ➊

messages=[{"role": "system", "content": system_message},{"role": "user", "content": query}],

temperature=temperature

)

p325. 예제 9.17 코드부 3~5째 줄

from llama_index import Document, VectorStoreIndex, ServiceContext

from llama_ import OpenAI index.llms

from llama_index import set_global_handler

→

from llama_index.core import Document, VectorStoreIndex, ServiceContext

from llama_index.llms.openai import OpenAI

from llama_index.core import set_global_handler

p326. 예제 9.17 코드부 첫 째줄

wandb_callback = llama_index.global_handler ➊

→

wandb_callback = llama_index.core.global_handler ➊

'+ 도서 오류 정보' 카테고리의 다른 글

| [정오표] 딱 한 줄로! 파이썬 제대로 코딩하기 (0) | 2024.11.11 |

|---|---|

| [정오표] 프리세일즈, 고객과 기업을 잇는 기술 대표 (0) | 2024.10.08 |

| [정오표] 대격변 AI 시대, 데이터로 사고하고 데이터로 리드하라 (0) | 2024.05.24 |

| [정오표] 디자인, 이것만 알면 쉬워져요 with 63가지 LESSON (0) | 2024.03.05 |

| [정오표] OpenAPI와 스웨거를 활용한 실전 API 설계 (3) | 2024.01.05 |

댓글